HISTOIRE DES TELECOMMUNICATIONS

TECHNOLOGIES DE BASE ET GRANDES INNOVATIONS TECHNIQUES

1. 1. INTRODUCTION A L'HISTOIRE DES TELECOMMUNICATIONS

1. 1. 1. Définition officielle du terme "Télécommunications"

Le terme télécommunications n'a été défini officiellement, pour la première fois, qu'à la conférence internationale de Madrid en 1932. En fait, jusqu'à cette date, il existait deux entités juridiques différentes, la Conférence internationale télégraphique, d'une part (la plus ancienne : elle avait été créée en 1865 à Paris) et la Conférence internationale radiotélégraphique (dont la première réunion s'était tenue à Berlin en 1906). En 1932, ces deux conférences se réunirent à nouveau, mais ensemble, à Madrid. La langue française, qui demeurait encore la seule langue officielle, fut utilisée pendant toute la conférence et pour la rédaction des actes finals. Il fallut d'abord trouver un nom pour la nouvelle organisation. Après discussions et échanges de vue, on s'entendit finalement sur l'appellation Union Internationale des Télécommunications (UIT). Quant au terme même de télécommunication il a été défini à la conférence de Madrid de la façon suivante :

« Toute communication télégraphique ou téléphonique de signes, de signaux, d'écrits et de sons de toute nature, par fil par radio ou autres systèmes ou procédés de signalisation électriques ou visuels (sémaphores) ».

La conférence de Madrid, qui fut la dernière conférence de plénipotentiaires avant la Seconde Guerre mondiale, marque la fin d'une époque, c'est-à-dire celle d'une période d'une cinquantaine d'années qui avait vu le développement du télégraphe, l'avènement et l'expansion prodigieuse du téléphone, puis l'apparition des radiocommunications.

C'est en 1947, à Atlantic City, aux États-Unis, que se tint la première grande conférence internationale de l'après-guerre. De multiples problèmes y furent abordés et étudiés, tant techniques qu'administratifs ou politiques. Les relations entre l'Organisation des Nations Unies et l'Union internationale des télécommunications furent précisées et, après bien des discussions, l'ONU donna son accord pour que l'UIT soit reconnue comme « l'institution spécialisée » en matière de télécommunications.

Une nouvelle définition du mot télécommunication fut adoptée tu cours de la Conférence d'Atlantic City. Cette version, qui n'est pas fondamentalement très différente de la première, constitue la définition officielle actuelle.

« On entend par télécommunication toute transmission, émission ou réception de signes, de signaux, d'écrits, d'images, de sons ou de renseignements de toute nature par fil, radioélectricité, optique ou autres systèmes électromagnétiques ».

Le contenu d'une télécommunication peut donc être pratiquement de n'importe quelle nature, mais le moyen de transmission doit être de type électromagnétique, ce qui est d'ailleurs très vaste, puisque l'on sait, depuis Maxwell, que les ondes électromagnétiques englobent l'électricité et l'optique. Une transmission par vole acoustique n'est donc pas, à proprement parier, une télécommunication.

1. 1. 2. Préhistoire des télécommunications

L'histoire des télécommunications modernes est relativement récente. Elle ne commence, en réalité, qu'il y a un siècle et demi, très exactement avec l'invention du télégraphe électrique par Samuel Morse en 1837. L'invention du téléphone par Alexander Graham Bell est encore plus récente puisqu'elle date de 1876, c'est-à-dire d'un peu plus d'un siècle seulement. Cependant, l'origine des télécommunications est beaucoup plus ancienne. Depuis toujours les hommes ont cherché à s’affranchir des barrières du temps et de l'espace; pour cela, ils se sont efforcés d'améliorer leurs moyens de communication et, plus particulièrement, la vitesse de transmission des informations à distance. Un des premiers moyens utilisé par les hommes pour communiquer à distance furent les feux, notamment dans le domaine militaire. Ainsi, dans l’Illiade, Homère parle de feux signalant l'approche d'une flotte venue aider les assiégés. Dans Agamemnon, Eschyle donne même le détail des relais lumineux utilisés : ils étaient situés au sommet de montagnes, telles que le mont Athos, le mont Cithéron, le mont Egiplancte, etc.; en tout 8 bonds couvrant quelque 550 kilomètres. N'est-ce pas là une préfiguration, plusieurs millénaires par avance, de nos actuels faisceaux hertziens, constitués par des relais espacés en moyenne de 60 à 80 km? On trouve ainsi de nombreux exemples historiques de transmissions de signaux par le moyen des feux. C'est à l'aide de feux allumés de colline en colline que le général romain Aetius fit parvenir à Rome la nouvelle de sa victoire sur Attila aux Champs catalauniques, en l'an 451 de notre ère. Plus généralement, des feux situés sur des points hauts, le long des grandes voies romaines, étaient utilisés pour transmettre rapidement des informations rudimentaires, essentiellement de caractère militaire. Dans le même ordre d'idées, on peut rappeler aussi qu'au vie siècle de notre ère, les Chinois utilisèrent, pendant le siège de Nankin, des cerfs-volants munis de lampes pour transmettre des signaux. On notera que ces procédés de communication, bien que très primitifs, mettaient en oeuvre des moyens optiques de transmission. La vitesse de transmission était déjà très convenable, mais la quantité d'information contenue dans chaque message était extrêmement faible, car les différentes configurations possibles des sources lumineuses étaient très réduites.

1. 1. 3. Début de l'histoire des télécommunications - Le télégraphe Chappe

En fait, la préhistoire des télécommunications s'étend sur des millénaires, mais on peut dire que l'histoire proprement dite des télécommunications ne commence qu'à la fin du XVIIIe siècle avec l'apparition, en France, du télégraphe optique de Claude Chappe. Ce télégraphe optique connut un grand succès à la fin du XVIIIe siècle et pendant toute la première moitié du XIXe siècle. On ne peut plus réellement parler, à ce sujet, de préhistoire des télécommunications. D'aucuns estiment même que l'ère des télécommunications s'ouvre avec la mise au point du télégraphe optique de Claude Chappe en France entre 1790 et 1793. Il paraît plus raisonnable de dire que l'invention de Chappe est un événement important de l'histoire des moyens de télécommunications. L'ère des télécommunications. modernes ne commencera réellement qu'avec l'invention du télégraphe électrique en 1837.

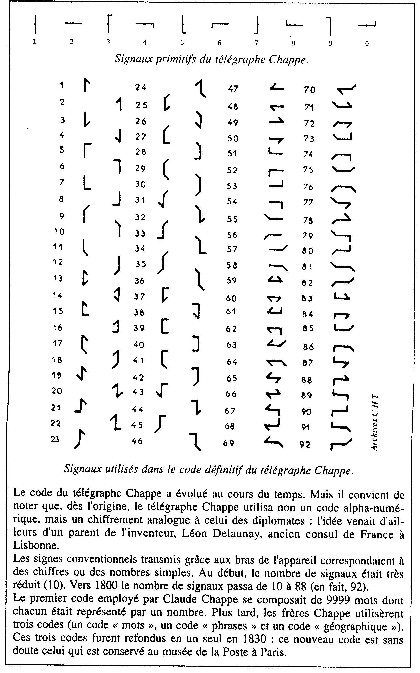

La machine télégraphique de Chappe s'apparentait, par son principe, aux sémaphores. Aux sommets de tours, en visibilité optique les unes des autres, était placé un système formé de trois bras articulés, commandés par un dispositif mécanique : chacun de ces bras pouvait prendre diverses positions. L'ensemble des combinaisons possibles constituait un code que l'on pouvait déchiffrer à distance grâce à des lunettes astronomiques : la distance entre les relais était, au plus, de quelques dizaines de kilomètres.

On se souviendra que la première liaison à grande distance fut réalisée sur ordre de la Convention, entre Paris et Lille. Cette liaison, longue de 230 km, fut construite en un temps record en 1793 et 1794. Sa mise en service eut lieu en août 1794 : la première dépêche, qui annonçait la reprise de Condé par les troupes de la République, fut transmise le 15 août de cette année.

Le télégraphe Chappe entrait ainsi dans l'histoire : toutefois il ne prendra vraiment son essor que quelques années plus tard, lorsque la deuxième liaison sera construite sur l'axe stratégique Paris-Strasbourg. Cette liaison, qui comprenait 50 stations, fut mise en service en 1798, la première dépêche transmise de Paris à Strasbourg, le 1er juillet 1798, annonçait que le général Bonaparte, au cours de sa traversée en direction de l'Egypte, s'était emparé de Malte. Après la ligne de l'Est, une ligne est établie, pour la Marine, entre Paris et Brest (1798), puis une autre en direction du Midi (1799). La liaison Paris-Lyon commandée par Napoléon, sera achevée en 1806, et prolongée rapidement jusqu'à Turin, puis, en 1809, jusqu'à Milan. A la même époque, la ligne du Nord, déjà prolongée jusqu'à Bruxelles en 1802, atteint Anvers en 1809. À l'étranger, la découverte de Chappe eut un grand retentissement. L'Espagne et l'Italie adoptèrent sans modification le système Chappe. L'Angleterre et la Suède, dont le climat brumeux posait des problèmes, construisirent des machines plus compliquées; la Belgique, la Hollande, le Danemark adoptèrent le système français; en Russie, le tsar Nicolas 1er fit appel à un ingénieur français pour établir des lignes entre Saint-Pétersbourg, Varsovie et Cronstadt : il inaugura lui-même, en 1838, la ligne Moscou-Varsovie qui comportait 220 stations desservies par 1320 opérateurs.

En France, le télégraphe aérien, comme on l'appelait, connut un grand développement. En 1844, la France dis, posait d'un réseau de 534 stations de sémaphores couvrant près de5 000 km; ce réseau, qui était essentiellement un réseau stratégique usage politique et militaire, ne fut jamais ouvert au public. Il ne faut pas oublier, non plus, que sa capacité de transmission n'était pas très élevée. Après 1845, le télégraphe électrique prendra peu à peu la place du télégraphe optique; en France, la dernière ligne du réseau de télégraphie aérienne sera retirée du service en 1859.

1. 1. 4. Début de l'ère des télécommunications modernes Invention du télégraphe électrique

Le télégraphe aérien portait en lui-même ses limites (très faible débit de transmission, impossibilité de transmettre par temps de brume et surtout la nuit, malgré toutes les tentatives faites pour trouver, une solution). En fait le télégraphe aérien fut essentiellement un moyen de communication disposition des pouvoirs publics. Il convenait très bien à un pouvoir aussi centralisé que celui qu'a connu la France sous la Révolution et l’Empire ; toutes les liaisons partaient d’ailleurs de Paris. Mais on ne peut considérer l'avènement du télégraphe aérien comme celui d’un nouveau média. Ce nouveau média, ce sera le télégraphe électrique. C'est lui qui ouvrira les portes de l’avenir et c'est pourquoi on peut considérer que l'ère des télécommunications modernes commence avec les premiers pas du télégraphe électrique, Plus précisément, c'est l'invention du télégraphe électrique par Samuel Morse, en 1837, aux États-Unis, qui constitue l'événement décisif. Certes, exactement à la même époque, Cooke et Wheatstone, en Grande-Bretagne, faisaient les premières démonstrations de leur « télégraphe à aiguilles » qui allait prendre par la suite une assez grande extension. La Grande-Bretagne sera même le premier pays à construire et à mettre en exploitation des liaisons télégraphiques, à partir de 1843.

Néanmoins, il ne fait aucun doute que la grande invention est celle de Samuel Morse. Morse, qui n'était ni un savant ni même un grand technicien, mais un artiste peintre, sut, en effet, concevoir un système d'une étonnante simplicité. Morse utilisa un code séquentiel à deux éléments seulement (le trait et le point) code très ingénieux d'ailleurs, puisque les séquences les moins longues correspondaient aux lettres les plus fréquentes, Ce qui est remarquable, et à proprement parier génial, c'est que le code inventé par Morse s'adaptera parfaitement à tous les moyens de communication futurs et notamment à la radio, aussi bien en phonie (lecteur au son) qu'en graphie. En quelque sorte, l'invention de Morse était un événement porteur d'avenir, et c'est à ce titre qu'il peut être qualifié d'historique et marque le début des télécommunications modernes.

1. 2. Les grandes mutations techniques des télécommunications

Il est toujours difficile de sélectionner, dans l'histoire d'une technique, une série de dates et de faits particulièrement significatifs. Nous pensons, cependant, que l'on peut retenir, depuis l'invention du télégraphe électrique par Samuel Morse, une liste d'une trentaine de dates et d'événements qui marquent l'histoire des télécommunications et qui sont à l'origine de profondes mutations techniques. On trouvera, dans le tableau 1.1, cette brève énumération, qui n'a d'autre prétention que de préciser quelques repères historiques.

Tableau 1. 1. : Les grandes mutations des télécommunications

1837 Un artiste peintre, Samuel Morse invente le télégraphe électrique et le fameux code qui porte son nom. L’ère des télécommunications modernes commence.

1866 Après de multiples péripéties et une véritable épopée qui dura près de dix ans, le premier câble télégraphique transatlantique est mis en service entre Valentia (Irlande) et Trinity Bay (Terre-Neuve).

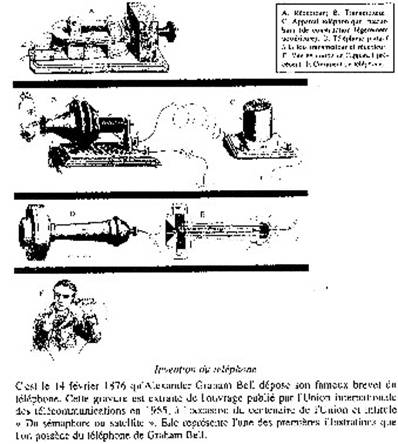

1876 Un professeur d'acoustique, Alexander Graham Bell, devançant de peu son compatriote Elisha Gray, dépose, le 14 février de cette année, son célèbre brevet sur le téléphone.

1877 Un agent de l'Administration française des PTT, Émile Baudot, invente le système télégraphique qui porte son nom. Ce système préfigure, près d'un siècle par avance, les futurs systèmes à modulation par impulsions et codage (codage binaire et multiplexage dans le temps).

1889 Almon B. Strowger, de son état entrepreneur de pompes funèbres à Kansas City, invente le premier «sélecteur » automatique. La commutation téléphonique automatique est née.

1896 Un jeune homme, chercheur et homme d'affaires entreprenant, Gugliemo Marconi, réalise la première transmission radiotélégraphique.

1900 Michael I. Pupin, professeur de physique à l'Université de Columbia, invente et met au point les bobines de charge. Ces « bobines pupin » permettront de réduire l’affaiblissement des câbles souterrains aux fréquences vocales. Les «Câbles pupinisés» seront utilisés pendant un tiers de siècle.

1902 Oliver Heaviside, en Angleterre, et Kennelly, aux États-Unis, prévoient que les «ondes courtes» pourront contourner la terre par réflexion sur l'ionosphère. Pendent un demi-siècle, les ondes courtes seront le seul moyen de communication intercontinentale en téléphonie.

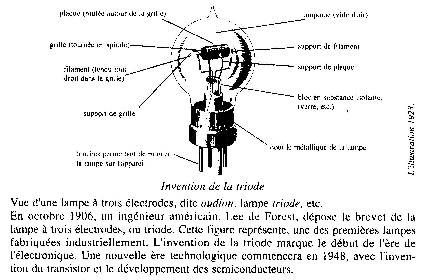

1906 Le 25 octobre de cette année, un ingénieur américain, Lee de Forest, dépose le brevet de la « lampe à trois électrodes », la triode. L'amplification des signaux télégraphiques et téléphoniques va devenir possible. L’ère de l'électronique commence.

1920 Au lendemain de la Première Guerre mondiale, la radiodiffusion sonore fait son apparition en France et en Grande-Bretagne. C'est également à cette époque que le premier « téléimprimeur » (Teletype-Creed) est mis au point (Angleterre) et que les premiers « systèmes à courants porteurs » font leur apparition (Western Electric - USA).

1927 Invention des « répéteurs à contre réaction » (H.S. Black - Bell Telephone Laboratories - USA).

1929 Premières émissions de télévision en Grande-Bretagne (Système Baird à analyse mécanique par disque de Nipkov). Réalisation d'une première caméra à 30 lignes en France (Barthelemy). Première démonstration du principe de « l'iconoscope », par Zworykin aux États-Unis.

1936 Pose des premiers câbles coaxiaux à grande distance aux États-Unis (New York - Philadelphie) et en Grande-Bretagne (Londres - Birmingham). Les câbles coaxiaux seront (avec les faisceaux hertziens après la Seconde Guerre mondiale) le support essentiel des liaisons à grande distance, pendant un demi-siècle.

1938 Alec Reeves (Laboratoire Central de Télécommunications - France) dépose le 3 octobre de cette année le brevet de base des futurs systèmes à modulation par impulsions et codage (MIC) : quantification et échantillonnage du signal à intervalles réguliers, puis codage sous forme binaire.

1945 Installation et expérimentation d'une première liaison à grande distance par faisceaux hertziens en hyperfréquences (bande des 4 GHz) sur le trajet NewYork - Philadelphie (Bell Telephone Laboratories-Western Electric - USA).

1948 Une équipe des Bell Telephone Laboratories, sous la direction (le William Shockley, invente le transistor. Une première présentation a lieu le 30 Juin 1948, mais il ne s'agit encore à cette date que d'un transistor « à pointes », Le transistor à jonction à base diffusée ne fera son apparition) qu’en 1955. On peut dire cependant qu’en 1948 s'ouvre une nouvelle ère technologique : celle des semiconducteurs.

1956 Un premier câble sous marin transatlantique, à amplificateurs immergés est posé par l'American Telephone and Telegraph company (AT&T) entre l'Écosse et Terre-Neuve (TAT1). Cette première réalisation marque le début d'une véritable explosion du trafic téléphonique intercontinental

1960 T.H. Maiman (Hughes Research Laboratories) réalise le premier laser effectivement utilisable (laser au rubis dopé chrome fonctionnant dans le rouge : 0,69 mm). Une nouvelle technologie se dessine. Mais il faudra, attendre l'apparition des fibres optiques, une quinzaine d'années plus tard, pour que les applications aux télécommunications puissent se développer.

1962 Les premiers systèmes de transmission multiplex de type MIC apparaissent aux Etats-Unis (Système T1 à 24 voies téléphoniques pour liaisons entre centraux téléphoniques). Une liaison transatlantique utilisant un satellite artificiel (Telstar) est établie dans la nuit du 10 au 11 juillet 1962, entre la station américaine d'Andover (Maine - USA) et la station française de Pleumeur-Bodou (Bretagne - France). C'est la première fois que des images de télévision sont retransmises entre deux continents. L'ère des télécommunications par satellite commence. La consécration de cet événement aura lieu en 1964, lorsque 14 pays « fondateurs » se réuniront pour créer le Consortium pour les télécommunications internationales par satellites, plus connu sous le nom d'Intelsat.

1965 Les recherches sur la commutation électronique ont commencé au cours des années 50 dans différents pays (États-Unis - Grande-Bretagne, France, notamment). Toutefois on peut retenir la date de 1965 comme celle marquant l'entrée de la commutation électronique dans les réseaux de télécommunications. C'est, en effet, en 1965 qu'a été mis en exploitation réelle le premier central téléphonique électronique à Succassuna (New Jersey, USA). Ce système utilisait la commutation électronique de type « spatial ».

1970 Un nouveau pas est franchi dans le domaine de la commutation électronique avec la mise en service en France, par le CNET, des premiers centraux téléphoniques publics en commutation électronique temporelle (Perros-Guirec, janvier 1970 - Lannion, juin 1970). L'avènement de la commutation électronique temporelle, faisant suite au développement rapide des systèmes MIC en transmission, marque réellement le début de l’ère des télécommunications numériques et de l'informatisation des réseaux de télécommunications. Deux autres événements déterminants pour l'avenir des télécommunications optiques sont à mentionner :

- démonstration par les Bell Telephone Laboratories du premier laser à semiconducteur (GaAs) fonctionnant en continu à la température ambiante. La longueur- d'onde de fonctionnement est 850 nm,

- la firme Corning Glass démontre qu'il est possible de réaliser des fibres optiques à faible atténuation. Les pertes sont de 20 dB/km à 850 nm, alors qu'elles étaient supérieures à 1000 dB/km dans l'état de l'art antérieur.

1975 On petit considérer que c'est au cours de cette année qu'apparaissent les premières liaisons expérimentales de télécommunications utilisant des fibres optiques. En particulier, à Atlanta (États-Unis), une liaison expérimentale à 45 Mbits/s. est établie sur un trajet de 650 mètres de longueur par les Bell Telephone Laboratories et la Western Electric. La perte en ligne est de l’ordre de 8 dB par kilomètre.

1979 C’est au début de cette année qu’est lancé, en France, un grand programme de vidéotex, le programme Teletel. Les terminaux Minitel vont connaître, en France, un succès rapide. Douze ans après le lancement de ce nouveau service, on compte déjà plus de 6 millions de terminaux, ce qui est considérable. Dans les autres pays le développement de ce service est beaucoup moins rapide.

1984 C’est au cours de cette année qu'apparaissent, aux États-Unis, les premiers réseaux de « radiocommunications cellulaires ». Le développement de cette nouvelle technique va être impressionnant, notamment aux États-Unis et dans les pays scandinaves (10 000 000 postes aux États-Unis en 1993).

1987 Mise en service du premier Réseau numérique à intégration de services (RNIS). C'est en effet à cette date, en France, qu'un tel réseau est effectivement ouvert, pour la première fois, au public (Saint-Brieuc - Décembre 1987).

1988 Le premier câble téléphonique transatlantique utilisant des fibres optiques est mis en service en décembre 1988 entre Tukerton (États-Unis), Widemouth (Grande-Bretagne) et Penmarch (France). Ce câble dénommé TAT8, comprend deux paires de fibres optiques pouvant transmettre des signaux à 280 Mbits/s par paire. La prédominance des liaisons par fibres optiques s'affirme, aussi bien dans le domaine des liaisons sous-marines que dans celui des liaisons terrestres.

1989 Un nouveau concept commence à s'imposer en télécommunications : celui de réseau intelligent (cf. notamment : < Conférence internationale sur les réseaux intelligents >, - Bordeaux, mars 1989). Un réseau intelligent est un réseau dans lequel l'intelligence des nouveaux services offerts par le réseau est concentrée dans des équipements spécialisés hors des commutateurs proprement dits. Il y a en quelque sorte une symbiose de plus en plus profonde entre télécommunications et informatique. La commutation électronique avait constitué une première étape dans ce sens. Le réseau intelligent va plus loin, car il intègre l'informatique non seulement aux commutateurs mais à l'ensemble même du réseau.

1990 Les bases des futurs réseaux de télécommunications à large bande se précisent. Les développements correspondants s'appuient, d'une part, sur les remarquables performances des fibres optiques et, d'autre part, sur de nouveaux concepts et technologies tels que :

- commutation temporelle asynchrone, ou ATM (Asynchronous Transfer Mode),

- hiérarchie numérique synchrone, ou SDH (Synchronous Digital Hierarchy).

En Europe, le programme Race (Recherches avancées pour les communications en Europe) se propose de fédérer les efforts de recherches de la Communauté européenne dans ce domaine.

Tels sont, depuis un siècle et demi, les principaux événements et les grandes mutations technologiques qui ont le plus marqué l'histoire technique des télécommunications. En fait, ces événements sont de trois ordres.

Ce sont d'abord les grandes inventions directement liées aux télécommunications : invention du télégraphe électrique, du téléphone, de la TSF, de la télévision, etc. Il s'agit réellement, dans ces cas, (le l'apparition de nouveaux médias. Un autre groupe d'événements importants comprend toutes les grandes innovations qui ont contribué au progrès technique des télécommunications : commutation automatique, commutation électronique, câbles coaxiaux, faisceaux hertziens, satellites de télécommunications, fibres optiques, nouveaux systèmes de modulation et de codage, etc. Enfin, on peut grouiller, dans une troisième rubrique, les grandes mutations technologiques qui débordent largement le seul domaine des télécommunications, mais dont l'impact a été considérable sur les techniques de communication : l'invention de la triode et des tubes à vide, l'invention du transistor et le développement impressionnant des circuits à semiconducteurs et de la microélectronique en général, l'invention du laser et la technologie de la nouvelle optique.

Quant au développement des techniques numériques et de l'informatique en télécommunications, il est à l'origine d'une profonde évolution de tout le secteur des télécommunications. On rappellera, à ce propos, que le concept d'organe de commande à programme enregistré s'est introduit, pour la première fois, en télécommunications, dans le domaine de la commutation électronique en 1960 (Central électronique prototype de Morris-Illinois - États-Unis). Ce concept de programme enregistré a, progressivement, révolutionné non seulement les systèmes de commutation mais, par la suite, les réseaux de télécommunication,, eux-mêmes, grâce aux remarquables développements du génie logiciel. À ce titre, l'énoncé des principes de base des ordinateurs à programme enregistré par Von Neumann en 1947, ne le cède nullement, en importance, à l'invention du transistor par William Shockley et son équipe en 1948. Tous les progrès des systèmes et des réseaux de télécommunications, depuis un quart de siècle, procèdent, en effet, des développements prodigieux de la physique du solide et des semiconducteurs d'une part et de l'informatique et des logiciels d'autre part.

1. 3. LA RÉVOLUTION DES CIRCUITS INTÉGRÉS: UN ENJEU STRATÉGIQUE MAJEUR POUR LES TÉLÉCOMMUNICATIONS

Nous venons de rappeler quelques dates qui ont marqué de grandes mutations dans la technique des télécommunications. Nous avons cité, en particulier, l'invention du transistor qui a ouvert une nouvelle ère technologique pour les télécommunications, l'informatique, l'automatique et bien d'autres secteurs. Cependant, la véritable révolution technologique a été celle des circuits intégrés à large intégration (LSI), puis à très large intégration (VLSI). Ces technologies avancées de semiconducteurs sont devenues un enjeu stratégique dans bien des domaines et, notamment, dans celui des systèmes et des réseaux de télécommunications. Aussi nous a-t-il paru souhaitable de rappeler succinctement, dans une courte note, les données essentielles de cette mutation technologique fondamentale.

1. 3. 1. Du « composant » au « système »

La mise en mémoire, le traitement et la transmission à courte ou longue distance, sous forme électronique, des informations de toute nature (voix, écrits, signaux, données, images fixes et animées) reposent sur l'existence de composants électroniques actifs qui permettent la réalisation des fonctions élémentaires nécessaires (mémorisation, amplification, échantillonnage...

Test de circuits intégrés à grande échelle

L'invention du transistor en 1948, par William Schockley et son équipe des Bell Telephone Laboratories ouvrait une ère technologique nouvelle qui préludait au développement prodigieux des télécommunications et de l'informatique. En fait, la grande mutation technique ne commencera véritablement qu'au début des années 1960 avec l'apparition des « circuits intégrés », puis, un peu plus tard, avec le développement des circuits intégrés à grande échelle (LSI) et à très grande échelle (VLSI). La photographie ci-dessus représente un banc de test de ces circuits dans les laboratoires du CNET à Grenoble.

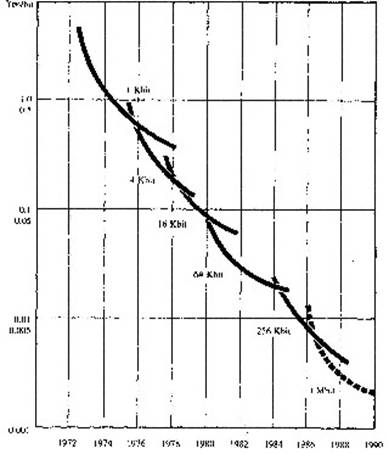

Au début de l'électronique, ces composants actifs étaient essentiellement constitués de tubes à vide. Depuis l'invention du transistor, en 1948, puis l'apparition des circuits intégrés au début des années 1960, les composants semiconducteurs ont pris la place des tubes à vide, en raison notamment de la miniaturisation de plus en plus poussée de ces composants. Cette miniaturisation ininterrompue a, en effet, entraîné à la fois une réduction continue du coût (fig. 1. 1), une baisse de plus en plus grande de la consommation en énergie, une augmentation croissante des performances et de la fiabilité. Elle a entraîné, en sens inverse, une « intégration » de plus en plus poussée de ces composants, en permettant de rassembler sur une même petite surface de semiconducteur de quelques millimètres carrés, des nombres de plus en plus grands de composants élémentaires. Les progrès accomplis ont été vertigineux, avec une loi quasi inéluctable de division par deux des dimensions élémentaires (et donc une multiplication par quatre du nombre de composants par unité de surface) tous les quatre ans. C'est ainsi qu'en une quarantaine d'années on a divisé par 1000 les dimensions élémentaires, en passant du millimètre au micron, et multiplié par 1 000 000 la densité des composants, avec aujourd'hui un million de transistors sur une surface équivalente à celle d'un confetti, surface nécessaire à l'origine pour réaliser un seul d'entre eux.

Figure 1. 1. : Evolution du prix du bit de mémoire (yen/bit)

Cette intégration toujours plus poussée a fait que ces composants de plus en plus puissants et complexes sont devenus de véritables fonctions électroniques et sont en passe de devenir de véritables systèmes par eux-mêmes. Le composant absorbe le système : on parle aujourd'hui de certaines puces en tant que microcalculateurs, blocs mémoires, convertisseurs analogiques-numériques, codeurs-décodeurs... C'est ainsi que la calculette de poche qui comportait une cinquantaine de composants électroniques différents il y a une dizaine d'années n'en a plus que deux aujourd'hui.

Cette évolution s'est accompagnée d'un transfert de la valeur ajoutée des systèmes vers les composants, dans la mesure où des onctions qui étaient obtenues autrefois par assemblage de composants plus simples, et donc réalisées par des équipementiers, sont obtenues aujourd'hui directement à l'intérieur des circuits intégrés et relèvent par conséquent de l'activité, et donc du chiffre d'affaires, des fabricants de composants.

1. 3. 2. Marché mondial des semi-conducteurs

Le marché des composants électroniques, dans son ensemble, est un marché considérable. On l'évaluait, en 1992, à 130 milliards de dollars, soit une fois et demie le marché mondial des équipements de télécommunications.

À l'intérieur de ce vaste marché des composants électroniques, le marché proprement dit des semi-conducteurs était évalué, à la même époque, à 60 milliards de dollars environ. Quant au taux de croissance de ce marché des semi-conducteurs, il se maintenait à un niveau élevé (plus de 10 % par an). Mais le secteur le plus intéressant de ce marché est celui des circuits intégrés qui, à lui seul, représentait, en 1992, 83 % du marché des semi-conducteurs et dont la croissance moyenne depuis 1987 était de plus de 12 % par an. Cependant on remarquera que ce taux de croissance moyen recouvre des situations très différentes selon les types de circuits : croissance de l'ordre de 20 % par an pour les mémoires et les microprocesseurs, qui représentent, à eux seuls, près de 60 % du marché des circuits intégrés, mais, a contrario, régression de l'ordre de 8 % par an des circuits bipolaires (source de documentation : OMSYC : Observatoire Mondial des Systèmes de Communication (20, avenue Rapp, 75007 Paris).

Jusqu'en 1990, le marché des semi-conducteurs était dominé de façon écrasante par les producteurs japonais (NEC, Toshiba, Hitachi, Fujitsu ... ). Depuis 1991, l'industrie américaine a fait un retour spectaculaire : Intel est devenu le premier producteur mondial, avec un chiffre d'affaires de plus de 5 milliards de dollars en 1992 et Motorola devance Hitachi. Quant au constructeur franco-italien SGS-Thomson il se situe au 13ème rang mondial avec un chiffre d'affaires de l'ordre de 1,5 milliard de dollars, derrière Philips (2 milliards de dollars) mais devant Siemens (1,2 milliard de dollars). Philips, SGS-Thomson et Siemens sont d'ailleurs les seuls constructeurs européens figurant dans cette liste des 20 premiers producteurs mondiaux de semi-conducteurs.

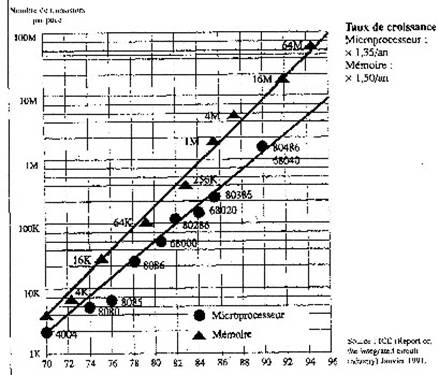

Les évolutions considérables observées dans le domaine des circuits intégrés ont de fortes chances de se poursuivre. Au plan technique, il est évident qu'on finira par se heurter à des barrières physiques (la nature granulaire de l'électricité et de la matière, en limites ultimes ... ). Mais on ne voit pas aujourd'hui de raison majeure pour que la plongée vers des miniaturisations de plus en plus poussées (et donc, à l'inverse, des intégrations de plus en plus élevées) ne se poursuive pas au même rythme jusqu'alors observé, au moins pour les dix ans à venir. La figure 1.2. montre l'évolution extraordinaire du nombre de transistors par puce depuis le début des années 1970.

Il semble bien que l'on s'achemine vers des densités de l'ordre de 100 millions de transistors par puce. À ce niveau d'intégration, la puissance élémentaire de ces composants est telle qu'ils deviennent des éléments stratégiques pour les futurs systèmes. Il n'est pas exagéré de dire que la maîtrise de tels composants peut conduire à l'hégémonie mondiale non seulement dans le domaine des composants eux-mêmes mais aussi dans celui des systèmes.

Figure 1. 2. : Cent millions de transistors sui- une même puce en 1995!

1. 3. 3. Les circuits intégrés et les télécommunications

Le monde des télécommunications a lui aussi connu l'intrusion puis l'envahissement des puces électroniques, à la fois par substitution dans les domaines d'emploi traditionnels des composants électroniques, comme dans les dispositifs de transmission, mais aussi par remplacement de techniques non électroniques, dans les autres domaines. C'est ainsi que la commutation, à l'origine électromécanique, a été entièrement bouleversée par les techniques de numérisation de la parole et de commutation temporelle, fondées sur des traitements électroniques de l'information et donc sur l'emploi des circuits intégrés électroniques.

L'expansion considérable des télécommunications, tout comme celle de l'informatique, s'est appuyée sur celle de la microélectronique, mais elle a aussi, réciproquement, nourri cette expansion. Certains services de télécommunications n'auraient pu pratiquement se concevoir sans les puces électroniques. C'est ainsi que le succès du vidéotex français a reposé sur le bas coût de son terminal, le Minitel et que, sans ces composants, il aurait été impossible de concevoir un terminal vidéotex à moins de 1000 francs et donc de franchir le « seuil d'amorçage » d'une diffusion grand public. Par leur emploi généralisé de circuits intégrés, les télécommunications représentent ainsi quelque 20 % du « marché mondial des semiconducteurs et jusqu'à près de 30 % pour le marché français.

En télécommunications, comme dans bien d'autres domaines, les circuits intégrés sont un élément important dans la réalisation des systèmes, et donc d'un poids élevé dans le chiffre d'affaires correspondant; mais ils sont aussi un facteur clef de l'innovation, puisque de la maîtrise de leur évolution dépendent la conception et les performances des futurs systèmes et services des télécommunications. Ce double aspect stratégique des circuits intégrés constitue un élément essentiel de toute politique de recherche et de développement en matière de télécommunications.

Concevoir les futurs systèmes et services de télécommunications nécessite en effet d'intégrer les perspectives d'évolution de ces éléments devenus indispensables dans l'architecture et les performances mêmes des futurs systèmes. Concevoir ces futurs systèmes et services nécessite aussi la réalisation des maquettes de faisabilité dans des technologies de pointe, si on veut éviter que ces conceptions et ces réalisations deviennent obsolètes au moment où l'on passera en production et un exploitation. La maîtrise des technologies des composants stratégiques est pour les télécommunications françaises un élément clef de leur compétitivité présente et future.

1. 4. LES COMPOSANTS OPTOÉLECTRONIQUES

Comme leur nom l'indique, les composants optoélectroniques permettent de transformer de l'énergie électrique en énergie lumineuse et réciproquement. Ils apparaissent donc d'emblée comme particulièrement importants dans un grand nombre d'applications qui vont du domaine grand public à celui du professionnel hautement spécialisé : visualisation, affichage, lecteur de codes barres, imprimante laser, lecteurs de disques compacts, caméscope, télécommunications, optronique militaire.. Les composants optoélectroniques assurent, entre autres, deux fonctions principales : l'émission et la réception.

L'émission correspond à la réalisation d'une source lumineuse. Cette source peut être incohérente (émission simultanée de plusieurs longueurs d'onde sans relation entre elles, analogue à l'émission d'une ampoule électrique classique). C'est la diode électroluminescente. Cette diode peut émettre dans divers domaines du spectre : l'infrarouge, le rouge, le vert et plus récemment le bleu. Une autre source, plus difficile à réaliser mais plus riche d'applications est la diode laser : son rayonnement est monochromatique, avec des propriétés de cohérence de phase et de directivité spatiale.

La réception est l'opération inverse, transformant un signal lumineux en un signal électrique facilement délectable et traitable à l'aide des outils et techniques habituels. La forme la plus simple à base de semi-conducteurs est la diode p-n (le plus souvent, c'est une structure un peu plus compliquée dite « p-i-n » avec une zone intrinsèque en sandwich entre les zones p et n qui est utilisée) complétée éventuellement par un élément préamplificateur tel que FET (transistor à effet de champ). Des performances supérieures de détectivité (sensibilité ... ) peuvent être obtenues avec des diodes dites à « avalanche » (abréviation usuelle APD pour avalanche photodiode) dans lesquelles une multiplication de porteurs, analogue à ce qui se passe dans un tube photomultiplicateur classique, est réalisée à l'intérieur même de la structure détectrice.

Dans les télécommunications, on recherche avec un très haut degré de priorité à utiliser des composants optoélectroniques à base de semi-conducteurs. Ceux-ci possèdent en effet de remarquables propriétés : compacité, haut rendement de conversion électrique-optique, faible tension d'excitation facilitant ainsi grandement les conditions d'utilisation, fiabilité... Tout élément ou composé semi-conducteur (Ge, Si, GaAs, InP, ... ) peut être utilisé comme récepteur basé sur les transitions entre bande de valence et bande de conduction. Il n'en est pas de même pour l'émission laser qui requiert une bande interdite directe et exclut donc le germanium et le silicium au profit des semi-conducteurs composés parmi lesquels l'arséniure de gallium (GaAs) et le phosphure d'indium (InP) sont les plus utilisés, ce dernier l'emportant largement. Les systèmes de télécommunications requièrent, pour être opérationnels, de mettre en oeuvre comme émetteurs des lasers à semi-conducteurs fonctionnant en continu à température ambiante avec possibilité de modulation directe par variation du courant d'excitation. Cela est simple à dire, mais plus difficile à réaliser! Il a fallu près de dix ans entre la première démonstration de l'effet laser dans un semi-conducteur (1962 pour un fonctionnement en impulsions à 4°K dans GaAs) et le premier fonctionnement en continu à la température ambiante (1970, avec une durée de vie très réduite!).

Comme cela a été signalé, la réalisation des premiers systèmes de télécommunications par fibres optiques a bénéficié du « miracle » de la conjonction de la « première fenêtre » de transmission des fibres à base de silice (3dB/km) avec le domaine d'émission de l'arséniure de gallium (0,85 mm).

Les améliorations de la fabrication des fibres ont permis de profiter de la deuxième (1,3 mm 0,4 dB/km) puis de la troisième (1,55 mm 0,2 dB/km) fenêtre. Ce sont les composés à base de phosphure d'indium qui sont adaptés à ces longueurs d'onde. Les composés quaternaires (In, Ga, As, P) et ternaires (In, Ga, A) ont fait l'objet d'études intensives depuis une vingtaine d'années pour aboutir aux composants aux propriétés remarquables actuellement utilisés et qui sont en cours d'amélioration continue. Ces propriétés et performances résultent de progrès dans la définition des structures (des matériaux massifs aux structures à puits quantiques) ainsi que, et sans doute surtout, dans la mise au point de nouvelles technologies d'élaboration (épitaxie par jets moléculaires, épitaxie en phase vapeur par décomposition de composés organométalliques). Ces technologies, qui supplantent l'épitaxie en phase liquide, permettent une précision ultime (la couche atomique) dans l'épaisseur des dépôts, leur composition, leur homogénéité sur de grandes surfaces, points essentiels pour atteindre les performances et la fiabilité requises.

1. 5. TÉLÉCOMMUNICATIONS ET INFORMATIQUE IMPORTANCE DU GÉNIE LOGICIEL

1. 5. 1. Introduction

Les systèmes de télécommunications et plus particulièrement les systèmes de commutation ont utilisé les techniques de type informatique, tant matérielles que logicielles, dès le courant des années 60. L'introduction de ces techniques a été engagée presque simultanément avec celle de l'électronique. L'utilisation de telles techniques se fait à différents niveaux :

Ø au niveau des services, par l'introduction de la numérisation et de techniques de transport et de traitement de données, aussi bien pour l'information fournie par les usagers que pour celle nécessaire à la commande du réseau (signalisation);

Ø au niveau des réseaux, par l'utilisation d'ordinateurs (ou calculateurs) programmés pour commander les noeuds de ces réseaux. Cette utilisation met en lumière l'importance du logiciel, lequel reflète l'« intelligence » du réseau et la qualité des services qu'il peut offrir,

Ø au niveau des techniques de développement de ces systèmes programmés, l'informatique pouvant, en effet, servir d'outil pour son propre développement.

1. 5. 2. La programmation dans les systèmes de télécommunications

Les premiers utilisateurs de calculateurs et de logiciels ont été, dans les années 60, les commutants qui ont vu dans ces techniques un moyen de faciliter la réalisation des logiques complexes contenues dans les commutateurs : logique de traduction d'acheminement, logique de taxation, etc. Les commutateurs étaient, à l'époque, réalisés sous forme électromécanique par utilisation de logiques à relais. Le passage direct à une logique programmée a certainement grandement facilité l'élargissement de la gamme des services fournis aux usagers, car cet élargissement pouvait être réalisé plus économiquement sous forme d'une évolution du logiciel de commande. À la fin des années 60, les systèmes de commutation électronique à commande par programme enregistré selon la terminologie de l'époque (en anglais SPC : Stored Program Control), disposaient de processeurs de commande développés spécialement pour les besoins de la commutation, avec une structure, un jeu d'instructions et des périphériques très spécifiques. Ceci supposait que l'on développât également des systèmes de support spécifiques comme on le verra plus loin. À cette époque, le volume du logiciel d'un commutateur était typiquement de quelques milliers d'instructions, les services rendus étant en gros équivalents à ceux fournis par un commutateur électromécanique.

Dans le courant des années 70, on s'est orienté vers 1'utilisation de calculateurs classiques, éventuellement adaptés aux besoins de performance en temps réel des systèmes à développer. Le domaine d'application de la technique de commande par calculateur s'est élargi, en particulier avec l'apparition des mini-ordinateurs : organes spécialisés raccordés aux systèmes électromécaniques et orientés vers l'exploitation (observation de trafic, taxation, etc.) ou la traduction d'acheminement-, commutation de données, réseau vidéotex. Dans le même temps, la complexité des systèmes et des services croissait, ce qui se reflétait dans l'accroissement du volume du logiciel : de la dizaine de milliers d'instructions en 1970, à la centaine de milliers en 1975, pour atteindre le million en 1980.

Les années 80 ont été marquées par le déferlement de la microinformatique dans tous les domaines; les télécommunications n'ont pas échappé à ce phénomène. Les microprocesseurs sont maintenant, non seulement utilisés dans tous les nouveaux systèmes et équipements de télécommunications (systèmes de gestion, systèmes de transmission, terminaux, etc.) mais également dans les organes périphériques des systèmes de commutation et non plus uniquement pour la commande centrale. Le volume des logiciels a pris une ampleur considérable.

À titre d'exemple, rappelons que le logiciel de la première version du système de commutation électronique temporelle E10 (Platon) comportait au début des années 70, quelque 50000 instructions. Aujourd'hui, les versions les plus sophistiquées de ce système en nécessitent plusieurs millions.

Dans le même temps, les constructeurs de matériel informatique ont conçu et réalisé des réseaux spécifiques pour relier leurs machines, éventuellement basés sur des techniques nouvelles (par exemple Ethernet), réseaux qui ont pris de l'ampleur et ne sont plus simplement locaux, mais peuvent couvrir tout un territoire, voire le monde entier; dans ce cas ils utilisent en général, l'infrastructure des réseaux de télécommunications pour le transport d'information (par exemple : lignes spécialisées, réseaux X25, etc.).

Pendant que les opérateurs de télécommunications mettaient des ordinateurs dans leur réseau, les informaticiens construisaient des réseaux pour relier leurs ordinateurs. Il en a découlé une certaine concurrence entre opérateurs de télécommunications et constructeurs informatiques pour la fourniture de services intégrant télécommunications et informatique. Il faut, toutefois, noter que chacun a gardé ses points forts sans vraiment remédier à ses points faibles : techniques pas très adaptées à la gestion d'un grand nombre d'abonnés dans le cas des réseaux informatiques, offre de services informatiques pas toujours satisfaisante dans le cas des réseaux de télécommunications, Cette concurrence s'est retrouvée au niveau des grands programmes européens (Esprit pour l'informatique, Race pour les télécommunications et aussi des organismes de normalisation, tant européens qu'internationaux, l'ISO pour l'informatique face au CCITT pour les télécommunications. La dichotomie informatique - télécommunications se retrouve même à l'intérieur du CCITT entre les commissions traitant respectivement de la commutation téléphonique et de la commutation de données.

Cependant, la nécessité de pouvoir raccorder les divers systèmes entre eux, tant informatiques que de télécommunications, a conduit à la définition de normes de protocoles pour interconnecter ces systèmes : normes OSI (Interconnexion de systèmes ouverts) pour les « protocoles en couches », dont les couches basses sont typiquement celles utilisées pour la commutation de données. Ce type de normes concrétise un besoin de convergence de deux mondes qui sont en concurrence sur certains secteurs, mais qui ne peuvent vivre l'un sans l'autre.

1. 5. 3. Techniques de développement

L'introduction de techniques informatiques et, en particulier, de la programmation dans les systèmes de télécommunications a nécessité de disposer de méthodes et d'outils pour le développement des logiciels de ces systèmes.

Tant que le volume du logiciel ne dépassait pas quelques milliers d'instructions (fin des années 60), une équipe de quelques personnes pouvait avoir la maîtrise complète de sa conception et de sa réalisation. On a alors cru au mythe de la souplesse d'évolution du logiciel, en s'imaginant que les extensions et les modifications des systèmes pourraient se faire à faible coût puisqu'il suffisait de changer le logiciel. En réalité, on s'est rendu compte, avec l'accroissement du volume du logiciel dû à l'élargissement de l'éventail des fonctions traitées, que son coût d'évolution est comparable à ceux de tous les systèmes complexes et que l'avantage du logiciel par rapport au matériel réside seulement dans son coût de reproduction pratiquement nul. Les techniques de développement de logiciels s'appuient sur un cycle de vie comprenant plusieurs étapes, qui sont classiquement : la spécification, la conception (ou l'analyse), la programmation (codage dans un langage de programmation), le test (mise au point), la validation. Ce cycle se répète complètement lors des évolutions des spécifications, et, plus ou moins partiellement, lors de la détection d'anomalies de fonctionnement.

L'informatique pouvant servir de support à son propre développement, des outils (logiciels) peuvent être utilisés lors de ces différentes étapes.

Au début des années 70, les seuls outils utilisés étaient les traducteurs de langage de programmation et, plus spécialement, le langage d'assemblage qui permettait d'utiliser directement les instructions de la machine. La raison invoquée pour l'utilisation de ce dernier type de langage était la nécessité d'avoir des programmes efficaces en temps d'exécution, et économes en volume de mémoire (l'octet de mémoire coûtait cher à l'époque). La fonction la plus importante du logiciel était l'établissement des communications. L'ordinateur de commande devait donc traiter simultanément un nombre important de tâches : en gros, une tâche par communication en cours d'établissement ou de libération, soit plusieurs centaines de tâches pour un commutateur traitant plusieurs dizaines de milliers d'abonnés. La commutation était donc considérée comme une application essentiellement temps réel, telles les applications de commande de processus industriels, et les outils utilisés étaient du même niveau qu'en informatique temps réel. Il y avait alors un certain décalage de techniques entre ce type d'informatique et l'informatique scientifique ou de gestion qui utilisaient des langages évolués (Fortran ou Cobol) depuis les années 50.

Comme nous l'avons indiqué précédemment, les années 70 ont vu l'accroissement exponentiel du volume du logiciel dont les fonctions se sont étendues, principalement par la prise en compte de services et de facilités d'exploitation et de maintenance d'importance grandissante. On a alors pris conscience que, puisque seul un noyau restreint de ce logiciel avait des contraintes temps réel fortes, il devenait intéressant, pour améliorer la productivité, d'écrire la majeure partie de ce logiciel en utilisant un langage évolué, même si celui-ci induisait une perte en performance; l'augmentation de puissance des ordinateurs et la baisse de leur coût a également favorisé cette évolution, la commande d'un système de commutation ne représentant plus qu'une faible part de son coût total. Là encore, la séparation informatique télécommunications s'est manifestée, puisque, pendant que la communauté informatique, sous l'impulsion du ministère de la Défense des États-Unis, définissait le langage Ada, le CCITT définissait le langage Chill (ou C), ces deux langages ayant des caractéristiques et des domaines d'application très voisins. A partir de cette époque, on a également pris conscience que la programmation n'était qu'une petite partie du problème de la conception et de la réalisation de logiciels, et des actions ont été lancées pour disposer d'outils d'aide dans les autres phases du cycle de vie, en amont pour la spécification et la conception et en aval pour le test et la validation.

La spécification étant la référence pour toutes les étapes du cycle de vie, il est indispensable que cette base utilise des formalismes permettant d'en vérifier certaines qualités : cohérence, non ambiguïté, complétude. Vers le milieu des années 70, le CCITT a défini un langage de spécification (LS) qui, depuis, a subi de nombreuses améliorations : essentiellement orienté à l'origine vers la spécification de systèmes de signalisation (il a été très utilisé pour décrire les interfonctionnements de systèmes de signalisation), il a été étendu pour prendre en compte tous les aspects des systèmes de commutation (protocoles plus généraux, traitement des données, etc.). Ce langage très prisé, même en dehors du monde des télécommunications, car il dispose à la fois d'une forme graphique et d'une forme textuelle, a maintenant le support d'un certain nombre d'outils industriels. Il convient toutefois de noter qu'une majeure partie des spécifications est encore écrite en langage naturel, ce qui ne facilite pas leur traitement automatique.

Pour ce qui concerne l'étape de test et de validation, en particulier dans le cadre de la recette des systèmes, les outils utilisés étaient très rudimentaires jusqu'au milieu des années 80 : simulateurs permettant de recréer l'environnement du système sur ses différentes interfaces (abonnés, circuits, relations homme-machine). L'enchaînement des opérations élémentaires restait fait de façon manuelle. On commence à disposer maintenant d'outils permettant d'exécuter des tests de manière automatique, ce qui garantit de pouvoir rejouer ces tests lors d'opérations de recette ultérieures consécutives à des évolutions du système (notion de test de non-régression). De plus, on voit également apparaître des langages de description de tests, en particulier le langage TTCN défini par l'ISO, plus spécialement adaptés aux tests de protocoles et résultant des actions européennes ou internationales menées dans ce domaine.

1. 5. 4. Nécessité et difficulté de l'industrialisation du logiciel

Les techniques de l'informatique sont, avec la microélectronique et l'optique, des techniques clés de l'évolution des télécommunications. Ceci est évident, à l'examen des progrès constatés depuis la fin des années 70; toutes les analyses prospectives concluent qu'il en sera de même pour l'actuelle décennie.

Une autre caractéristique majeure de l'évolution des télécommunications est l'importance croissante prise par la gestion des réseaux : exploitation, maintenance, configuration, programmation... Aux besoins en informatique temps réel pour la commutation clé voies téléphoniques ou de données s'ajoutent, désormais, des besoins (le plus en plus importants en informatique de gestion.

Dans le domaine du matériel (optique, microélectronique), les évolutions sont relativement prévisibles car elles résultant de bonds technologiques dont on peut estimer, avec une certaine marge d'erreur, la nature et la date d'apparition. L'évolution du logiciel est, en revanche, plus difficile à cerner. En matière de programmation, le bilan des faits marquants des trente dernières années peut paraître, en effet, assez maigre : les seuls facteurs ayant eu un impact réel sur la productivité (disparition des supports papier au profit des terminaux de visualisation interactifs, amélioration des temps de réponse dans le processus de développement) sont essentiellement a mettre au crédit de l'évolution du matériel.

Par ailleurs, les langages de programmation restent peu ou prou au même niveau que ceux définis vers la fin des années 60, tandis que les langages de spécification et de conception son( encore loin de tenir leurs promesses. À ce jour, le principal intérêt (le ces derniers est de fournir un formalisme qui permet de communiquer sans ambiguïté, ce qui n'est pas le cas des langages naturels. Schématiquement, on pourrait dire que si le logiciel, par les moyens de CAO (conception assistée par ordinateur) qu'il a permis de développer, a été la base de l'accroissement considérable de productivité en développement matériel, en revanche, son impact sur son propre processus de développement s'est révélé quelque peu décevant.

Que peut-on conclure de cette évolution et quelles sont les perspectives pour les années à venir? Tout d'abord, une certitude : il est exclu que les courbes de croissance enregistrées pendant les quinze dernières années soient extrapolables. Un récent rapport du Department of Defense (DOD) des États-Unis montre que, pour la seule maintenance de ses logiciels, il faudrait employer la moitié de la population active des Etats-Unis vers 2015. Comme nous l'avons rappelé, les étapes du développement des logiciels sont : la spécification, la conception, la programmation, le test et la validation. Elles sont d'ailleurs semblables à celles du développement des matériels et l'on peut certainement, pour le logiciel, tirer grand profit des approches et des méthodes du développement du matériel. Il apparaît, de fait, de plus en plus nécessaire de développer une « industrie du logiciel », comme il existe déjà une industrie du matériel.

La conception et l'exploitation de très grands logiciels requièrent, en effet, la mise en oeuvre de véritables méthodes industrielles. Un système de commutation électronique temporelle, tel que le E10 B2 (version récente du système E10) aurait nécessité, avec les méthodes artisanales du début des années 70, le travail d'environ 300 programmeurs pendant 7 ans. Les « ateliers » de logiciel sont une tentative pour réduire les délais et les coûts, Ces ateliers ont pour but d'organiser la coopération et l'échange de données entre informaticiens en leur offrant la possibilité de faire communiquer entre eux de multiples outils (compilateurs, éditeurs, metteurs au point, analyseurs de qualité...). Si, par exemple, une spécification a changé, l'atelier indique à l'écran toutes les parties du logiciel à modifier. Il produit organigrammes, graphiques et tests de validation, maintenant par là, en permanence, la cohérence et la mise à jour de l'ensemble.

La validation d'un logiciel de commutation prend de six mois à un an. Elle consiste à simuler un maximum de cas possibles pour vérifier que le logiciel ne se laisse pas prendre en défaut. Il est, en réalité, impossible de tout prévoir et de tout vérifier! Or, le désir d'offrir très vite des services nouveaux et sur mesure aux grands clients pousse à raccourcir les délais. L'objectif est de les réduire à quelques mois en utilisant au mieux les techniques informatiques appropriées : langages de spécification et de programmation, validation et génération automatique des jeux tic tests à partir de spécifications formelles, bases de données « orientées objet » (00). En ce qui concerne la maintenance, la difficulté tient à ce qu'un logiciel ne peut être réparé comme une voiture en remplaçant la seule pièce défaillante. Chaque modification en un endroit risque de provoquer des perturbations ailleurs. Pour juger de la qualité d'un logiciel, il faut, non seulement, conduire des tests fonctionnels de validation mais procéder aussi à une analyse statistique du programme, examiner sa structure, sa documentation, ses mots clés... Si la procédure de contrôle apparaît trop complexe pour des opérations d'exploitation, il convient d'y remédier.

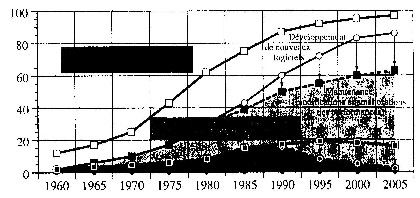

Tels sont quelques préalables auxquels il faut satisfaire si l'on veut effectivement pouvoir parler d'industrialisation du logiciel et amélioration de la productivité dans ce domaine (Figure 1.3).

Figure 1. 3. Importance croissante du Logiciel.

L'importance croissante du logiciel en télécommunications apparaît clairement lorsque l'on examine la répartition du coût des grands systèmes de télécommunications entre matériel et logiciel. Au début des années 1970, le coût des systèmes de commutation électronique, par exemple, était réparti sensiblement entre 80 % pour le matériel et 20 % pour le logiciel. À partir de la décennie 1990, les proportions s'inversent : 80 % pour le logiciel et 20 % seulement pour le matériel. Ces chiffres illustrent la véritable révolution qui s'est produite dans ce domaine en une vingtaine d'années. La figure donne une idée de cette évolution. Elle montre aussi les efforts qui sont entrepris en génie logiciel pour abaisser les coûts de maintenance et de corrections d'erreurs qui ont tendance à devenir prépondérants dans ces nouveaux systèmes de télécommunications. Cette figure est extraite de la revue France Telecom (n°78 - juillet 1991).

À notre avis, un des points clés pour l'amélioration de la productivité, réside dans la réutilisation du logiciel, réutilisation qui implique :

Ø des normalisations internationales couvrant tous les domaines; sous la pression des utilisateurs, constructeurs et organismes internationaux, il a été entrepris un gros travail de normes en langages, systèmes opératoires, protocoles de communication, supervision des réseaux... Ceci permet la portabilité ainsi que la réutilisation des sous-ensembles les plus complexes du logiciel;

Ø la constitution de bibliothèques réutilisables pour les télécommunications, comme c'est le cas pour la programmation scientifique qui dispose de bibliothèques mathématiques largement utilisées.

Réutilisation aussi poussée que possible des « composants logiciels » et généralisation de la « portabilité » des logiciels, de façon à assurer le maximum d'indépendance des applications vis-à-vis des matériels, sont des l'acteurs déterminants de l'évolution du génie logiciel.

En reprenant l'analogie avec le développement du matériel, il est impératif que les développeurs de logiciels s'orientent vers l'utilisation de « composants » du marché. Alors qu'actuellement le concepteur de matériel travaille avec ce qu'il a à sa disposition (cartes, composants), le concepteur de logiciel a encore la possibilité de « réinventer » tout son environnement; bien souvent, il pense même que là est la base de son métier et de sa valeur ajoutée! Le problème relèverait-il, alors, plus de la psychologie que de la technologie? C'est une véritable révolution culturelle qu'il convient d'entreprendre. Là réside le défi des années à venir en logiciel. Sinon il est à craindre que la productivité en logiciel ait tendance à stagner et les coûts de réalisation à augmenter encore.