Transmission Numérique

Objectifs

- Caractériser un système de communication numérique en bande de base.

- Déterminer l'occupation spectrale d'un train d'impulsions.

- Déterminer la capacité d'un canal de communication à transmettre un signal binaire.

- Identifier les sources principales d'erreurs de transmission.

- Utiliser le diagramme de l'œil pour évaluer les imperfections d'un canal de transmission.

- Reconnaître les codes d'impulsions utilisés dans la transmission en bande de base.

- Justifier le choix d'un code d'impulsions pour une application donnée.

- Reconnaître les différentes méthodes de détection et de correction d'erreurs.

- Reconnaître les différents codes de vérification d'erreurs utilisés en téléinformatique.

3.1 Introduction

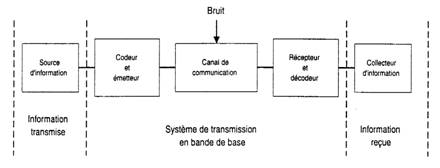

L'échange de l'information en bande de base entre deux points géographiquement éloignés l'un de l'autre nécessite un certain nombre d'éléments de base illustrés par la figure 3.1.

Figure 3.1 : Système de transmission en bande de base.

Ce système simplifié est composé d'une source et d'un collecteur d'information reliés par un système de transmission en bande de base. La source de données peut générer l'information sous différentes formes: chiffres, symboles, mots, graphiques, etc. Le codeur et l'émetteur transforment cette information en une suite binaire sous la forme d'un train d'impulsions acceptable par le support de transmission. Le canal de communication peut être une. ligne de transmission métallique, une fibre optique, l'air ou un autre lien de transmission. C'est à ce niveau que la qualité du signal peut être détériorée par la présence de bruit ou par un certain nombre de défauts inhérents au canal choisi et qui seront les sources principales d'erreur. Enfin, le récepteur détecte les signaux auxquels s'est ajouté le bruit et les interprète correctement avant que le décodeur ne les transforme sous une forme acceptable par le collecteur de données.

3.2 Rapport signal à bruit

Dans un système de transmission en bande de base, le signal transmis représente les niveaux logiques 1 et 0. Supposons que le niveau haut transmis est de 4 V. Par contre, le récepteur détecte un niveau haut à partir de 2 V. Il ne faut alors en aucun cas que le bruit ne dépasse 2 V et en conséquence le rapport signal à bruit défini par :

doit être supérieur à 6 dB puisque

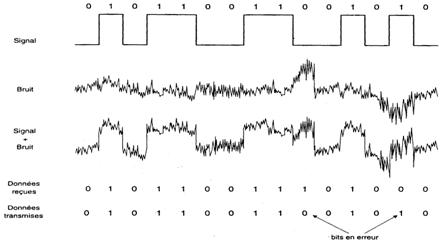

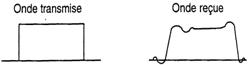

La figure 3.2 illustre comment les impulsions de bruit dépassant 2 V peuvent être interprétées comme de niveau 1, provoquant ainsi des erreurs de transmission.

Figure 3.2 : Effet du bruit sur la transmission d'un signal numérique.

3.3 Transmission d'une suite d'éléments binaires

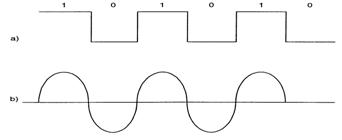

La figure 3.3 montre que la suite binaire 1 0 1 0 1 0 transmise à un taux de N bps véhicule l'information exactement comme un signal sinusoïdal dont la fréquence serait égale à N/2 Hz.

Figure 3.3 : Transmission d'une suite binaire.

Nyquist, en 1928, a prouvé théoriquement qu'un canal de transmission dont la bande passante est égale à N/2 Hz peut véhiculer N éléments du signal par seconde. Pourtant, un signal binaire sera considérablement arrondi à la sortie d'un tel canal. Il est facile d'en expliquer la raison par la composition spectrale donnée par l'analyse de Fourier. En général, un signal périodique non sinusoïdal est composé d'une série d'harmoniques selon la formule:

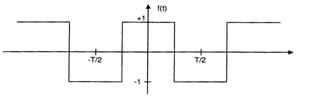

La série de Fourier d'un signal carré tel que présenté sur la figure 3.4 sera composée d'une série d'harmoniques impaires donnée par la formule:

Figure 3.4 : Signal carré

Le spectre d'un tel signal ne contient pas de composante continue ni de termes en sinus. Seuls la fondamentale et les harmoniques impairs sont présents.

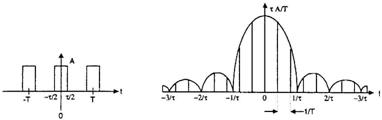

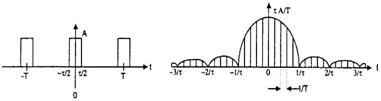

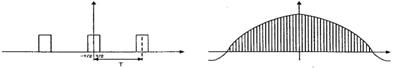

Considérons maintenant le spectre d'un train d'impulsions tel que présenté par la figure 3.5.

Figure 3.5 : Spectre d'un train d'impulsions.

Figure 3.6 : Spectres de différents trains d'impulsions en fonction de T et de t

Nous remarquons que le spectre est composé d'un certain nombre de valeurs discrètes et que l'enveloppe du spectre peut être exprimée par l'équation :

Il est facile de déduire que si la période T devient plus petite (plus d'impulsions par seconde), les lignes spectrales s'éloignent d'avantage; par contre si T augmente, les lignes spectrales deviennent de plus en plus serrées et, à la limite, forment un spectre continu qui est celui d'une seule impulsion. Puisque la plus grande partie de l'énergie se trouve entre l'origine et 2/t, il est fréquent de considérer la bande passante requise comme étant égale à 2/t. La figure 3.6 donne le spectre de différents trains d'impulsions en fonction de T et de t.

En conclusion:

- la largeur d'impulsion la plus courte détermine la bande passante requise pour le transport d'un train d'impulsions,

- une impulsion étroite nécessite une bande passante plus large qu'une impulsion large.

- les lignes spectrales d'une seule impulsion forment un spectre continu sous forme de sinx/x.

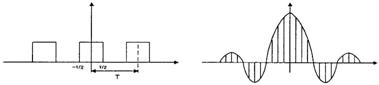

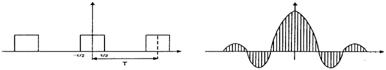

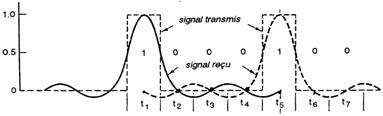

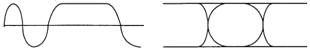

Si les impulsions passent par un filtre à bande limitée, chaque symbole va être entaché de l'interférence créée par les symboles précédents et suivants. Ce phénomène d'interférence entre symboles est illustré par la figure 3.7.

Figure 3.7 : Illustration du phénomène d'interférence entre symboles.

Nous remarquons qu'aux instants t2, t3 et t4, les spectres des deux impulsions passent par zéro. Ceci nous permet de constater l'importance de choisir une fréquence d'échantillonnage égale au débit binaire et que cet échantillonnage ait heu au milieu de chaque impulsion.

3.4 Capacité du canal de communication

La capacité maximale théorique d'un canal de communication en présence de bruit a été énoncée par Shannon dans l'équation suivante :

où

où C désigne la capacité maximale du canal en bps, W sa bande passante en Hz et S/N le rapport en mW/mW (ou en W/W) de la puissance moyenne du signal à la puissance moyenne du bruit blanc.

Exemple 3.1

Calculez la capacité maximale d'un canal de communication dont la bande passante est de 4 kHz et le rapport signal à bruit de 20 dB.

Solution

Dans l'équation 3.5, le rapport signal à bruit est donné en dB. Ce rapport de 20 dB vaut 100 mW/mW La capacité maximale du canal est donc égale à:

C = 3,32 x 4000 log10 (1+100) = 26670 bps

Un système de codage multi-niveau n'augmente pas cette capacité théorique puisque le rapport signal à bruit décroît au fur et à mesure que le nombre de niveaux au ente. Il permet pourtant de s'approcher de la limite théorique.

En pratique, le débit binaire se situe entre le quart et la demie de la limite théorique. Le modem opérant à 9600 bps sur une ligne téléphonique dont la bande passante est de 4 kHz environ utilise un système de codage à 16 niveaux.

3.5 Transmission de données sur un canal de qualité téléphonique

La qualité des signaux propagés sur un circuit téléphonique ou un autre canal de communication peut être dégradée par les défauts du canal ou par la présence de bruit, ce qui provoque des erreurs de transmission. Dans les paragraphes suivants, nous allons identifier les sources principales de ces erreurs.

3.5.1 Affaiblissement ou atténuation du signal

L'affaiblissement du signal est provoqué par les pertes dans les liens de transmission. Elle est fonction de la distance parcourue sur le support de communication et de la fréquence du signal transmis.

Cette distorsion d'atténuation est fonction de la racine carrée de la fréquence et n'a donc pas beaucoup d'effet sur un signal numérique. Il faudra seulement s'assurer qu'à la réception les niveaux logiques puissent être détectés correctement.

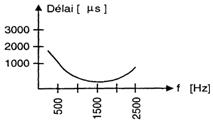

3.5.2 Distorsion de phase ou de délai

Dans une ligne de transmission, la vitesse de propagation du signal varie avec sa fréquence. Les différentes composantes de fréquence se propagent alors à des vitesses différentes. La distorsion de délai ou de phase est définie comme étant la différence entre le temps de propagation d'une fréquence donnée et le temps de propagation d'une fréquence de référence de 1500 Hz située au milieu de la bande passante du circuit téléphonique. Ce temps, appelé temps de propagation groupe, se mesure en microsecondes (figure 3.8). La figure 3.9 illustre l'effet de la distorsion de délai sur le signal reçu.

Figure 3.8 : Temps de propagation de groupe en fonction de la fréquence.

Figure 3.9 : Illustration de l'effet de la distorsion de délai sur le signal reçu.

3.5.3 Bruit

Dans tout système de communication réel, on doit tenir compte du bruit s'introduisant sur le canal de communication. Mesuré en décibel, le rapport de la puissance moyenne du signal à la puissance moyenne du bruit est un paramètre très important. En télécommunication numérique, trois types de bruit peuvent avoir des effets néfastes sur la performance du système: le bruit thermique, le bruit d'impulsion et la diaphonie.

3.5.3.1 Bruit thermique

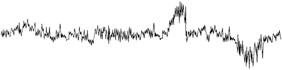

La figure 3.10 montre un oscillogramme du bruit gaussien. Ce bruit thermique, appelé aussi bruit blanc ou bruit gaussien, est généré par l'agitation thermique des électrons dans un conducteur ou dans un sen à conducteur. Ce type de bruit ne peut être négligé dans la transmission de données que si le rapport signal à bruit ne dépasse pas un certain niveau.

Figure 3.10 : Un oscillogramme du bruit gaussien.

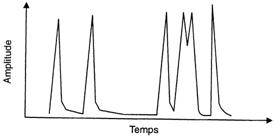

3.5.3.2 Bruit d'impulsion

Ce type de bruit, causé par les commutateurs électromécaniques (systèmes d'allumage d'automobile, moteurs, génératrices, etc.) ou par des problèmes externes au système de communication, se présente sous forme d'impulsions de courte durée et de grande amplitude. Les impulsions ainsi générées provoquent en général des erreurs à la réception. La figure 3.11 montre un oscillogramme de bruit d'impulsion.

Figure 3.11 : Un oscillogramme de bruit d'impulsion.

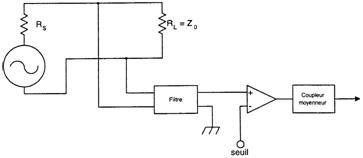

Il est possible de mesurer le bruit d'impulsion par un dispositif de mesure illustré à la figure 3.12. Le dispositif compte le nombre moyen d'impulsions dépassant un seuil donné sur une ligne téléphonique de la façon suivante:

- la ligne doit être terminée à ses deux extrémités par une impédance égale à son impédance caractéristique;

- un filtre passe bas doit être utilisé pour limiter la bande passante à 3000 Hz,

- le temps;

- les résultats doivent être enregistrés pendant 15 minutes et les mesures répétées à plusieurs moments du jour et de la nuit.

Figure 3.12 : Dispositif de mesure du bruit d'impulsion.

3.5.4 Diaphonie

La diaphonie (crosstalk) ou bruit de fond est causée par des interférences de conversations téléphoniques entretenues par deux paires d'interlocuteurs empruntant des lignes voisines.

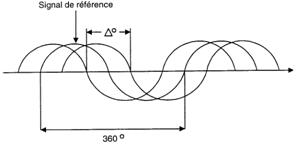

3.5.5 Gigue de phase et saut de phase

La gigue de phase (jitter) consiste en des variations de la phase du signal reçu par rapport à la phase du signal transmis (figure 3.13). Cet effet se produit lorsque les différents cycles du même signal passent par zéro à des instants différents. Cette distorsion, dont l'effet sur la transmission de la voix est négligeable, peut affecter sérieusement la transmission de données à taux élevé où le temps alloué à un bit est très court.

Figure 3.13 : La gigue de phase.

Pour mesurer la gigue de phase, un détecteur de passage par zéro du signal (zero crossing detector) mesure l'écart entre le nombre de passages à zéro du signal tel que généré par l'émetteur et le signal reçu.

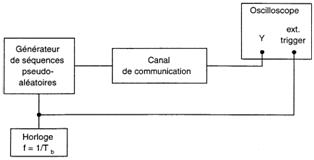

3.6 Mesure des interférences ; diagramme de l'œil

Dans la pratique, on évalue les imperfections du canal par l'observation d'un « oeil » obtenu en visualisant le signal reçu sur un oscilloscope. Le train d'impulsions des données est appliqué sur l'entrée verticale de l'oscilloscope pendant qu'il est déclenché par l'horloge d'échantillonnage des données. La constante de temps de l'oscilloscope est ajustée à un temps presque égal au temps alloué à un bit. Un dispositif de mesure du diagramme de l'œil est illustré à la figure 3.14. La figure 3.15 montre quelques diagrammes d'œil obtenus pour différents types de signaux reçus.

Figure 3.14 : Un dispositif de mesure du diagramme de l'œil.

Signal reçu Diagramme de l'œil

Figure 3.15 : Quelques diagrammes d'œil pour différents types de signaux reçus.

3.7 Codage des signaux numériques

En général, les lignes de transmission ne laissent pas passer la composante continue d'un signal, ce qui les rend mal adaptées à la transmission d'information binaire en bande de base. Les récepteurs répartis le long de la ligne et les transformateurs placés à ses extrémités éliminent cette composante continue, ce qui rend impossible de transmettre et de recevoir une longue suite de 1 ou de 0. Il est donc important de modifier les suites binaires afin de mieux les adapter aux caractéristiques des différents liens de communication.

Les codes d'impulsions les plus utilisés peuvent être classés en quatre catégories principales:

a) codes d'impulsions à NON- RETOUR À ZÉRO (NRZ)

b) codes d'impulsions RETOUR À ZÉRO (RZ)

c) codes d'impulsions à CODAGE DE PHASE (BIPHASE)

d) codes d'impulsions MULTINIVEAUX

Dans le choix et l'évaluation d'un type de codage, quatre critères peuvent être considérés :

1. Spectre du signal

Dans le cas d'un signal qui ne contient pas de composante continue, un couplage par transformateur sera possible et une excellente isolation électrique est assurée. D'autre part, un signal qui ne contient pas de composantes à haute fréquence requiert une bande passante moins large pour le transporter. 2. Synchronisation

En transmission synchrone, une réplique parfaite de l'horloge de l'émetteur doit être générée par le récepteur afin de synchroniser les deux équipements. Certains codes permettent cette synchronisation en générant une transition à chaque valeur binaire.

3. Possibilité de détection d'erreur

La nature même de certains codes permettent de développer des méthodes simples de détection d'erreur.

4. Immunité aux bruits

Certains codes possèdent de meilleures performances que d'autres en présence de bruit.

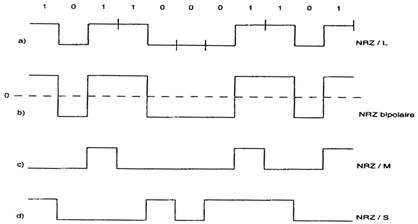

3.7.1 Codes HRZ

a) Le code NRZ/L (Non Retour à Zéro de niveau)

Tous les codes NRZ sont caractérisés par deux niveaux de tensions : l'un pour l'information 0 et l'autre pour l'information 1. Le niveau de tension se maintient pendant toute la durée d'un bit. Dans le codage unipolaire, le bit 1 est représenté par une tension positive et le bit zéro par une tension nulle. Par contre, dans le codage bipolaire, le bit 1 est représenté par une tension positive et le bit zéro par une tension négative.

b) Les codes NRZ/M (Mark) et NRZ/S (Space)

Dans le code NRZ/M, les informations 1 sont représentées par un changement de niveau au début d'un intervalle de temps alors que les informations 0 correspondent à l'absence de changement de niveau. Le code NRZ/S est le réciproque du précédent. Un changement de niveau du signal au début d'un intervalle correspond à une information 0 alors qu'aucun changement correspond à une information 1. La figure 3.16 présente ces différents types de codage NRZ pour la même séquence binaire.

Figure 3.16 : Les différents types de codage NRZ pour la même séquence binaire.

3.7.2 Caractéristiques des codes HRZ

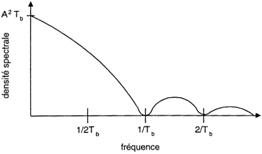

Les codes NRZ sont simples à générer et à coder. Cette simplicité en fait les codes les plus utilisés pour générer et traiter l'information binaire. Par contre, ils ont une forte composante continue et présentent le défaut de conserver le même niveau de tension pour une série de bits identiques, ce qui les rend inadaptés à la transmission synchrone. Le spectre du signal, présenté à la figure 3.17, est le même pour les trois types NRZ où une grande quantité d'énergie du signal se retrouve entre 0 et 1/Tb Hz.

Figure 3.17 : Le spectre du signal est le même pour les trois types NRZ

3.7.3 Codes RZ

a) Code RZ unipolaire

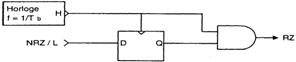

Dans ce code, une information 0 est représentée par une absence d'impulsion pendant l'intervalle de temps alloué à un bit alors qu'une information 1 est représentée par une tension positive qui occupe la première moitié de la durée du bit (ou la moitié de la période de l'horloge), la deuxième moitié étant à zéro. Il est facile de générer le signal RZ à partir du signal NRZ.

La figure 3.18 présente un schéma de principe ainsi que les formes d'ondes générées.

Figure 3.18 : schéma de principe ainsi que les formes d'ondes générées.

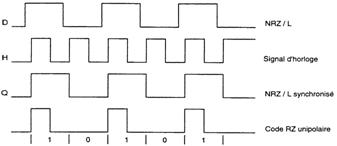

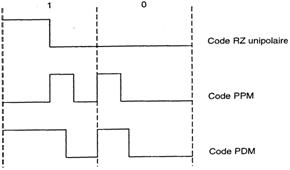

b) Modulation d'impulsion en position (ou PPM: Pulse Position Modulation) et modulation d'impulsion en durée (ou PDM: Pulse Duration Modulation)

Dans le codage PPM, une impulsion dont la durée est de Tb/4 située dans le premier quart de l'intervalle Tb représente l'information 0. Pour représenter l'information 1, la même impulsion se trouve dans le troisième quart de l'intervalle Tb. Pour représenter l'information 0, le code PDM génère une impulsion occupant le premier tiers de l'intervalle Tb tandis que l'information 1 est représentée par une impulsion occupant les deux tiers de l'intervalle Tb. La figure 3.19 illustre les trois types du code RZ.

Figure 3.19 : Les trois types du code RZ.

3.7.4 Caractéristiques des codes RZ

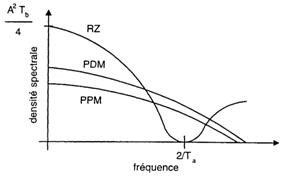

Les spectres des trois codes RZ sont présentés à la figure 3.20. La composante continue est beaucoup plus faible que pour le code NRZ; par contre, ils occupent une bande passante plus large vers les hautes fréquences. Les codes PPM et PDM facilitent la synchronisation en ce sens qu'il est simple d'en extraire le signal d'horloge.

Figure 3.20 : Les spectres des trois codes RZ.

3.7.5 Codes d'impulsions à codage de phase

Tous les codes à codage de phase ou les codes biphases requièrent une transition pendant l'intervalle Tb et ce, autant pour l'information 0 que pour l'information 1.

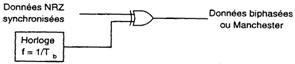

a) Code BI-L (Biphase-L) ou Manchester

Ce code divise Tb en deux intervalles égaux. Pour représenter l'information 1, une tension positive occupe la première moitié de l'intervalle Tb. Par la suite, une transition vers une tension nulle se produit et occupe la deuxième moitié de Tb. L'information 0 est représentée par une transition vers une tension positive qui se produit au milieu de Tb. Il est facile de générer le signal Biphase-L à partir du signal NRZ synchronisé avec un signal d'horloge. La figure 3.21 illustre un schéma de principe ainsi que les formes d'ondes correspondantes.

Figure 3.21 : Schéma de principe ainsi que les formes d'ondes correspondantes.

b) Code BI-M (Biphase-M)

Ce code offre toujours une transition au début de l'intervalle.

On représente l'information 1 par une transition au milieu l'intervalle de temps Tb, et l'information 0 par l'absence transition au milieu de Tb.

c) Code BI-S (Biphase-S)

Ce code est l'inverse du code précédent : aucune transition ne s produit au milieu de Tb pour représenter l'information 1 alors que l'information 0 en nécessite une.

d) Code DM (Delay Modulation) ou code Miller

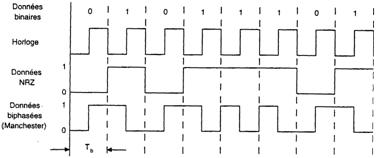

Dans ce code, l'information 1 est représentée par une transition au milieu de l'intervalle Tb alors que l'information 0 es représentée par une transition à la fin de l'intervalle Tb si le hi suivant est 0, et l'absence de transition si le bit suivant est 1. La figure 3.22 illustre la représentation des codes BI-L, BI-M et DM.

Figure 3.22 : Représentation des codes BI-L, BI-M et DM.

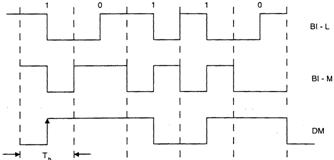

3.7.6 Caractéristiques des codes à codage de phase

Les codes à codage sont auto-synchronisants puisqu'il est facile d'extraire le signal d'horloge à partir du signal reçu.

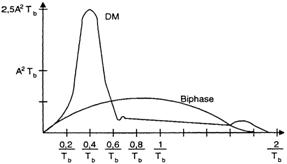

La figure 3.23 illustre les spectres des codes biphases. Nous remarquons l'absence de composante continue ; on note également que le code Miller requiert une bande passante moins large que le code NRZ.

Figure 3.23 : Les spectres des codes biphases.

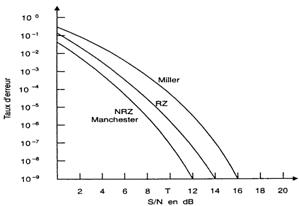

Enfin, la figure 3.24 montre l'évolution du taux d'erreur en fonction du rapport signal à bruit pour les différents codes.

Figure 3.24 : L'évolution du taux d'erreur en fonction du rapport signal à bruit pour les différents codes.

3.8 Détection et correction d'erreurs

En transmission analogique, le signal reçu peut être distorsionné et/ou brouillé. En transmission numérique, l'élément binaire peut être reçu avec une valeur différente de celle qui a été émise; tout le message associé en sera alors changé.

Les causes d'erreur sont nombreuses et dépendent principalement des lignes de transmission utilisées, du type de liaison locale ou interurbaine), du nombre de répéteurs franchis, du support de transmission (radio, satellite, fibres optiques, etc.) ainsi que du type de modulation et de codage utilisé.

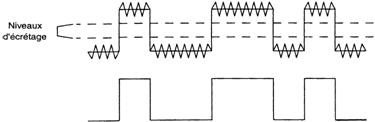

Le bruit thermique peut aussi provoquer des erreurs si son niveau devient quantifiable. Dans la pratique, lorsque cette situation se produit, il est facile de l'enlever et de reconstituer le signal binaire par un simple écrêtement comme le démontre la figure 3.25.

Figure 3.25 : Reconstitution du signal binaire par écrêtement

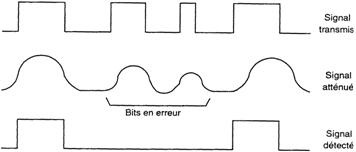

Le bruit d'impulsions est une source importante d'erreur en transmission de données. La figure 3.26 montre qu'une impulsion qui dure une dizaine de millisecondes peut induire plusieurs bits en erreur et que le nombre de bits en erreur augmente avec la vitesse de transmission.

Figure 3.26 : Illustration de l'effet du bruit sur un signal binaire transmis.

L'affaiblissement ou l'atténuation du signal est une source d'erreur puisque le niveau logique haut peut être détecté comme niveau bas si son amplitude devient inférieure à une tension de seuil (figure 3.27).

Figure 3.27 : Les erreurs provoquées par l'affaiblissement du signal

Le taux d'erreur est défini comme étant le rapport du nombre de bits erronés reçus au nombre total de bits transmis, Par exemple, un taux d'erreur de 10-3 signifie qu'un bit sur 1000 est erroné. Ce taux peut varier entre 10-3 et 10-7, ce qui est intolérable dans la majorité des applications téléinformatiques.

3.9 Méthodes de détection et de correction d'erreurs

Des systèmes de détection et de correction d'erreurs ont été développés pour protéger l'intégrité de l'information binaire émise. Ces systèmes sont basés sur un codage supplémentaire de l'information à l'émission et sur une analyse du message à la réception. En cas d'erreur, une demande de retransmission est envoyée à l'émetteur. Mais, dans certains cas, on peut aussi procéder à une correction automatique des erreurs au niveau du récepteur. Dans les paragraphes qui suivent, nous décrirons quelques méthodes de détection et de correction d'erreurs.

3.9.1 Vérification de parité

Cette méthode est la plus simple. Elle est caractérisée par l'envoi d'un bit supplémentaire, dit bit de parité, à la fin de chaque caractère. Ce bit vaudra 0 ou 1 selon la parité choisie (paire ou impaire) et le nombre de 1 contenus dans chaque caractère.

À la réception, la vérification de la parité permet de détecter certaines erreurs. La figure 3.28 représente trois caractères ASCII avec les bits de parité paire qui leur sont associés. Cette méthode simple de détection d'erreur n'est pas suffisante si un nombre pair de bits sont erronés dans un même caractère. Supposons qu'à la réception les deux derniers bits du code représentant le chiffre 3 aient été changés. Le bit de parité correspondant sera toujours le même et le récepteur ne détecte aucune erreur de parité. L'implantation matérielle de cette méthode est très simple.

caractère

code

bits de parité

A

1

0

0

0

0

0

1

0

3

1

1

0

0

1

1

0

0

L

0

0

1

1

0

0

1

1

Figure 3.28 : Représentation de trois caractères ASCII.

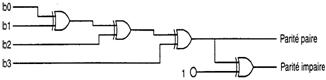

La figure 3.29 montre un circuit de génération ou de vérification de parité d'un mot binaire de 4 bits.

Figure 3.29 : Circuit de génération ou de vérification de parité d'un mot binaire de 4 bits.

3.9.2 Vérification de parité longitudinale et transversale

Cette méthode représente une amélioration par rapport à la méthode précédente puisque sur un bloc composé de plusieurs caractères, on génère un bit de parité par ligne et un bit de parité par colonne. On obtient ainsi un bit de parité par caractère et un caractère de parité pour chacun des blocs du message tel qu'illustré à la figure 3.30.

N° du caractère

Code

Bits de parité

1

0 1 0 1 0 1 1

0

2

1 1 0 1 0 0 1

0

3

0 0 1 0 1 1 0

1

4

1 0 0 0 1 1 0

1

5

0 1 1 0 0 1 0

1

6

1 0 1 1 0 0 1

0

7

1 1 0 1 1 0 1

1

Caractère de parité

0 0 1 0 1 0 0

Figure 3.30 : Vérification de parité longitudinale et transversale.

Au caractère no4, nous remarquons que deux bits sont erronés. Le bit de parité associé à ce caractère ne sera pas changé mais le caractère de parité du bloc sera modifié et une erreur de transmission sera signalée.

3.9.3 Code M dont M (8 dont 4)

Dans ce code, 4 bits sur 8 sont toujours à 1. Ainsi, la nature de ce code permet de détecter une erreur chaque fois que le nombre de bits à 1 n'est pas égal à quatre.

3.9.4 Codes redondants cycliques (CRC)

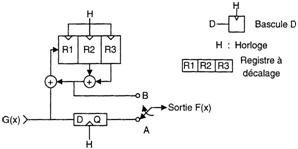

De tous les codes linéaires (le codage et le décodage sont des opérations linéaires), les plus populaires sont les codes cycliques (CRC : Cyclic Redundancy Check). Ces codes sont simples à implanter avec des registres à décalage et un petit nombre de portes OU-exclusif Ils possèdent également la capacité de détecter des erreurs indépendantes ou se produisant par paquets. Cette méthode permet de détecter 99,95 % des erreurs.

Un message codé selon cette méthode comprend n bits dont k bits pour l'information utile. La différence (n-k) est le nombre de bits dans le caractère de vérification du bloc (BCC : Block Check Character).

Il faut deux polynômes pour former le message codé F(X): le polynôme générateur P(X) et le polynôme du message G(X) contenant l'information utile. Il existe des normes mathématiques pour les polynômes générateurs. Les polynômes suivants sont parmi les plus courants :

- CRC-12 X12 +X11 +X3 +X2 +X1 +X0

- CRC-16 X16 + X15 + X2 + X0

- CRC - CCITT(V.4 1) X16 + X12 + X5 + X0

Sous forme binaire, on place 1 à chaque position contenant un terme en X et 0 s'il y a absence de terme. Par exemple, la suite binaire du CCI'RT (V.4 1) est 10001000000100001.

L'avis V.41 du CCIIT recommande le choix de blocs de message d'une longueur :

n = 240, 480, 960 ou 3840 bits

À chaque bloc transmis s'ajoutent 4 bits de service Le BCC contient 16 bits (toujours 1 bit de moins que le polynôme générateur). Par exemple, le nombre total de bits dans un bloc de 3840 bits utiles sera égal à 3860 bits.

Par un exemple très simple, nous allons illustrer la génération du BCC et, conséquemment, le message codé.

Exemple 3.2

Soit le message G(X) = X3 + X1 = 1010 et le polynôme générateur P(X) = X3 + X0 = 1001

Le caractère de vérification du bloc BCC a toujours 1 bit de moins que le nombre de bits de P(X). Dans ce cas, le BCC aura 3 bits. On sait maintenant qu'il y a 4 bits de données et 3 bits de contrôle ; le message codé F(X) aura donc 7 bits.

Pour générer le message codé F(X) :

1. multiplier le message G(X) par Xn-k;

2. diviser en modulo 2 le résultat par le polynôme générateur P(X), sans tenir compte de la retenue.

3. sans tenir compte du quotient, additionner le reste de l'opération C(X) à Xn-k pour former le message codé.

Dans notre cas :

Xn-k = X3

Xn-k = G(X) = X3(X3+Xl) = X6 + X4 = 1010000

La division par P(X) se fait de la façon suivante :

1 0 1 0 0 0 0 1 0 0 1

1 0 0 1 1 0 1 1

0 0 1 1 0 0

1 0 0 1

1 1 1 1 0

Å 1 0 0 1

0 1 1 1

On obtient le message codé en ajoutant le reste C( X) à Xn-k .G (X), soit :

1 0 1 0 0 0 0

+ 1 1

F(X) = 1 0 1 0 0 1 1

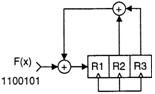

La figure 3.3 1 montre le circuit qui génère F(X).

OU-EXclusif

Figure 3.31 : Circuit de génération du message codé

Le tableau 3.1 résume la façon dont l'encodeur génère le message codé F(X) en supposant qu'initialement R1 = R2 = R3 = 0.

Impulsion d'horloge

Entrée G(X)

Position du commutateur

Rl

R2

R3

Sortie F(X)

1

2

3

4

5

6

7

1

0

1

0

-

-

-

A

A

A

A

B

B

B

1

0

0

1

0

1

1

0

1

0

0

1

0

1

0

0

1

0

0

1

0

1

0

1

0

0

1

1

Tableau 3.1 : le message codé F(X) généré par l'encodeur.

À la réception toute erreur sera reconnue par un circuit de détection tel qu'illustré à la figure 3.32.

Figure 3.32 : Circuit de détection d'erreur du message reçu

Le tableau 3.2 présente le contenu des registres après 7 impulsions d'horloge.

Impulsion d'horloge

R1

R2

R3

1

1

0

0

2

0

1

0

3

0

0

1

4

1

0

0

5

0

1

0

6

0

0

1

7

0

0

0

Tableau 3.2 : le contenu des registres après 7 impulsions d'horloge.

À la fin de l'opération, si le contenu du registre est de 000, aucune erreur ne sera signalée. Dans le cas contraire, l'équipement demandera à l'émetteur de retransmettre le message.

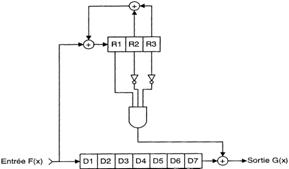

Il est aussi possible d'implanter un décodeur qui effectue la correction automatique. Un tel décodeur est illustré à la figure 3.33.

Figure 3.33 : Décodeur de correction automatique.

Décalage

F(X)

R1

R2

R3

D1

D2

D3

D4

D5

D6

D7

Sortie

1

1

1

0

0

1

-

-

-

-

-

-

-

2

0

0

1

0

0

1

-

-

-

-

-

-

3

1

0

0

1

1

0

1

-

-

-

-

-

4

1

0

0

0

1

1

0

1

-

-

-

-

5

0

0

0

0

0

1

1

0

1

-

-

-

6

1

1

0

0

1

0

1

1

0

1

-

-

7

1

1

1

0

1

1

0

1

1

0

1

-

8

-

1

1

1

-

1

1

0

1

1

0

1

9

-

0

1

1

-

-

1

1

0

1

1

0

10

-

0

0

1

-

-

-

1

1

0

1

1

11

-

1

0

0

-

-

-

-

1

1

0

0

12

-

0

1

0

-

-

-

-

-

1

1

0

13

-

1

0

1

-

-

-

-

-

-

1

1

14

-

1

1

0

-

-

-

-

-

-

-

1

Tableau 3.3 : Les contenus des registres.

3.9.5 Circuits intégrés pour générer des polynômes

Les fabricants de circuits ont développé des circuits intégrés à grande échelle pour générer les polynômes standards. À titre d'exemple, le MC8503P (Universel Polynomial Generator) est un générateur programmable permettant d'implanter les six polynômes suivants :

X16+ X15 + X2 + X0

X16 + X14 +X + X0

X16 + X12 + X5 + X0

X16 + X11 + X4 + X0

X16 + X0

X8 + X0

3.10 Codes pour correction automatique

Il y a des situations où on ne peut se permettre, en cas d'erreurs, de demander la retransmission du message, par exemple, dans 1 traitement de l'information en temps réel et dans les communications par satellites. Des codes spéciaux ont été développés pour répondre à ces besoins. Ces codes permettent une correction automatique des erreurs par le récepteur. Le prix à payer pour implanter ces codes est l'ajout d'un nombre de bits redondants au message, rendant ainsi la transmission moins efficace. Nous allons maintenant analyser l'un de ces codes, appelé code Hamming, développé par R.W H g au laboratoire de Bell aux Etats-Unis.

3.10.1 Code Hamming

Ce code requiert un certain nombre de bits redondants qui s'ajoutent au bloc du message. Le nombre maximum de bits du message codé est donné par:

2H - 1

où H est le nombre de bits redondants. Avec 4 bits redondants, un message codé de 11 bits d'information aura un total de 15 bits.

Exemple 3.3

Nous voulons implanter le code Hamming pour coder un message contenant 8 bits d'information. Il nous faudra ajouter 4 bits de Hamming pour former le message codé. Au total, le message codé aura 12 bits.

Position des bits

12

11

10

9

8

7

6

5

4

3

2

1

bits d'information

0

1

0

1

0

0

1

0

bloc du message codé

0

1

0

1

H

0

0

1

H

0

H

H

Les bits de Hamming sont placés aux positions correspondantes à 2n (dans notre cas:1, 2, 4 et 8).

Dans le message codé, des informations «1» se trouvent à la position 5, 9 et 11, Pour trouver les valeurs des bits redondants «H», on effectue l'opération OU-exclusif entre les chiffres 5, 9 et 11 convertis en binaire.

Le message codé transmis sera le suivant :

0 1 0 1 0 0 0 1 1 0 1 1

Supposons que le 9e bit soit erroné dans le message codé reçu. Le message codé reçu serait alors:

H H H H

0 1 0 0 0 0 0 1 1 0 1 1

Pour déterminer la position du bit erroné, le récepteur effectue l'opération OU-exclusif entre les bits de Hamming et les chiffres 5 et 11 indiquant les positions des bits «1»

Le résultat de cette opération indique la position du bit erroné; récepteur n'a qu'à inverser son état.

Telle que décrite, cette méthode peut détecter et corriger l'erreur d'un bit seulement. On peut détecter qu'il y a 2 bits erronés ou plus, mais sans pouvoir les corriger.

3.11 Efficacité de transmission

3.11.1 Efficacité de transmission d'un caractère

L'efficacité est définie comme étant le rapport entre le nombre de bits d'information et le nombre total de bits transmis. En code ASCII, si on ajoute le bit de parité au caractère transmis, l'efficacité du code sera:

0,875 ou 87,5 %

De plus, si le mode de transmission choisi est le mode asynchrone avec un bit de départ et un bit d'arrêt, l'efficacité dû au mode de transmission sera de:

ou 80 %

L'efficacité totale est alors obtenue par le produit des deux:

Exemple 3.4

Un équipement transmet des caractères ASCII au taux binaire de 300 bps. À quelle vitesse l'information utile est-eue transmise, en supposant qu'un bit de parité est ajouté à chaque caractère et que la transmission se fait:

a) en mode synchrone, en négligeant les bits de synchronisation?

b) en mode asynchrone avec 2 bits d'arrêts?

Solution:

a) En mode synchrone:

ou 87,5 %

ou 100 %

ou 87,5 %

Le débit de l'information utile :

b) En mode asynchrone :

Le débit binaire de l'information utile est donc:

3.11.2 Efficacité de transmission d"un bloc de message

En pratique, la transmission d'un message requiert plusieurs caractères de contrôle. L'efficacité est alors définie par le rapport suivant :

Exemple 3.5

Un réseau téléinformatique utilisant le code ASCII en mode asynchrone (1 bit de départ et 2 bits d'arrêt) est relié à un terminal qui envoie des messages de 200 caractères en moyenne, plus 20 caractères pour indiquer le nombre de caractères dans le texte, vérifier les erreurs et identifier le terminal d'origine de même que celui de destination. Quelle est l'efficacité totale de la transmission du texte Em et le débit binaire de l'information RI si le terminal transmet à 300 bps?

Solution :

et Rl = 300 - 0,58 = 174 bps.